PinokioやHuggingFaceで発見し、気になっている人もいるかと思います。いったい何ができるの? 状態の人向けに、デモを少し触ってみたので感想を書きます。

AI Video Composerとは?

AI Video Composerとは、自然言語を使用して、アセットから新しいビデオを作成するものらしいです。

“引用説明:

ビデオ、画像、オーディオ アセットを追加すると、Qwen2.5-Coder によって新しいビデオが生成されます (FFMPEG を使用)。”

Hugging Faceにデモが公開されているので、触ってた感想を共有します。

https://huggingface.co/spaces/huggingface-projects/ai-video-composer

(ちなみに、Qwen2.5はアリババが発表したLLMです)

https://x.com/Alibaba_Qwen/status/1836449414220779584

説明を見る限り、自然言語で指示を出すと、その内容に従って、オーディオ・映像素材を編集する指示文を生成 (具体的には、ffmpegコマンドを生成)し、それによって、自動で与えた素材が編集されるという仕組みのようです。

…ということは、そもそも限られたことしかできないのでは?

と思いますが、とりあえず指示文を与えるだけで、何も考えずにすぐに編集ができるという効率性だけをみれば面白そうです。

(今回、Pinokio経由でローカルに落とせたので、そちらでも触ってみてますが、Hugging Faceに公開されているほうが、結果的に使いやすかったので、そのリンクを共有しています。)

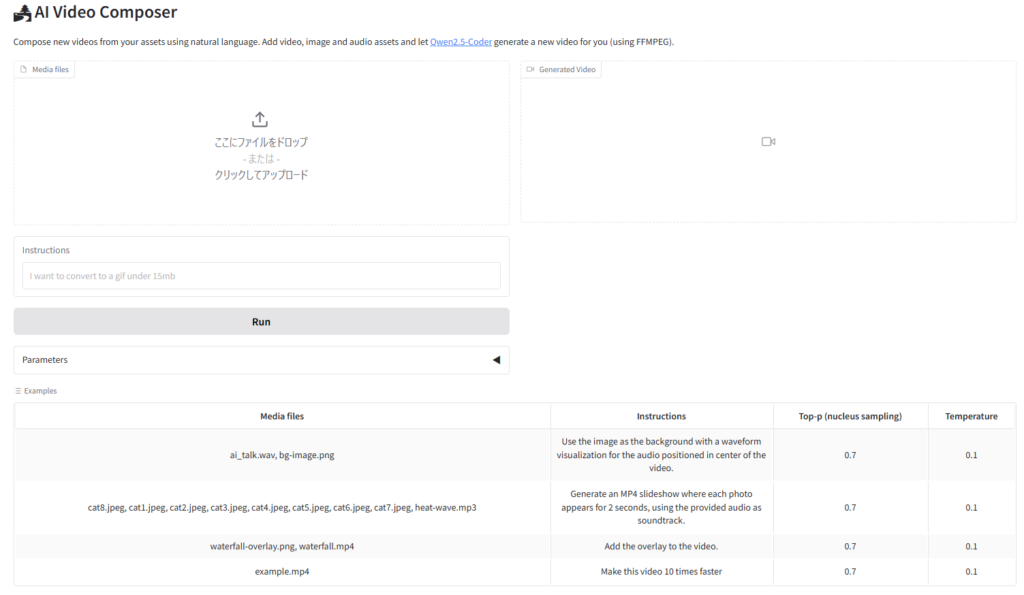

デモ画面 (左: 素材アップロード、指示文挿入、パラメータ、右: 結果)

ちなみに、デモで公開されているプロンプトを見てみると、

Make this video 10 times faster. (10倍速?)

Use the image as the background with a waveform visualization for the audio positioned in the center of the video. (画像を背景として使用し、オーディオの波形を視覚化してビデオの中央に配置。)

Generate an MP4 slideshow where each photo appears for 2 seconds, using the provided audio as the soundtrack. (写真が 2 秒間ずつスライド表示され、音楽が流れるスライドショーを生成。)

Add the overlay to the video. (ビデオにオーバーレイを追加)

情報が少ないですが、結局のところffmpegのコマンドに依存するのでは、

ということで、とりあえず波形をだして遊んでみました。

結果

Prompt:

Use a looped video as a background. Visualize your audio as a ring wave. The color of the waveform is light blue. The audio waveform is in a ring shape, giving the effect of the waveform radiating out from the center.

背景動画はFlora AIというのでつくりました。(Florafauna.ai)

感想

なんだか、個人的に拍子抜けでしたが、ffmpegすごいなっていうのを改めて知り勉強になりました。驚き屋さんのように、AIで編集できる時代がきた!!とか言いたかったですが、そういうことではなさそうです。(表面的な情報だけでみてるので、間違ってたらすみません。ただ、コマンドエラーも発生していたので、もはやGPTでffmpegのコマンドを生成する方が、精度も良さそうとも思いました。)

GPTを触りまくった今、何にも驚かなくなってる状態ですが、よく考えたら自然言語の指示文でコマンドがでるって、本当はすごいですね。

コメントを残す