はじめに

Anthropicが先日、GPT4より性能の良いClaude3というモデルを発表しました。

Claude 3 Haiku、Claude 3 Sonnet、Claude 3 Opusという3種類がコストと性能に応じて用意されています。HaikuのみAPI利用がまだできませんが、他はAPI利用可能です。

ちなみに料金はOpsが入力 が「 $15 / 1M tokens」で、出力が「 $75 / 1M tokens」です。GPT4より高価です。これは自信の現れですね。

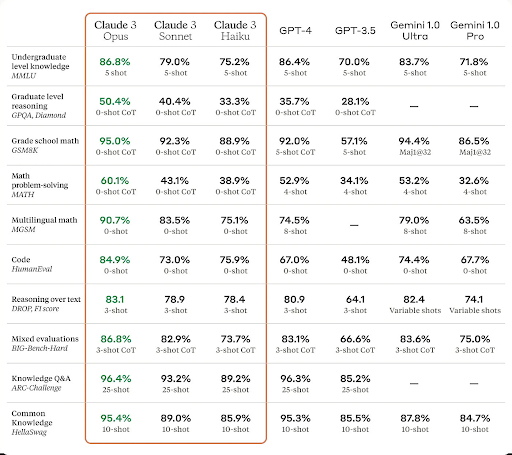

Anthropicが発表していたモデルのベンチマークの結果が下記です。

GPT4との比較でも、特にOpusは全ての項目で優れている結果になっています。

Googleなどが発表するこういうベンチマークの結果は、自分のところのモデルが有利になるような方法でテストしていることが多いです。(◯-shotの部分が自分のモデルだけ多いとか)、ただ今回は同じ条件かGPTより不利な条件ですので結構信憑性がありそうです。

今回は鷹の目を持つ私がその真意について検証してみます!

ちなみにClaudeはOpsで検証します。

検証-1「しりとり」

昨年GPTが話題になった頃にしりとりを試してみて出来なかった記憶があったので、試してみました。

■プロンプト

しりとりを10回してください。今回は「ノーベル」からスタートしてください。 ■しりとりのルール 1.前の単語の最後の音から始まる単語を言う 2."ん"で終わる単語を使うことは禁止 3.一度出た単語を使用することは禁止 4.「ー」で終わる場合はその一個前の音から始まる単語を言う ■例 「りんご」→「ゴリラ」→「ラッパ」→「パンツ」→「つみき」→「きもの」→「ノート」→「とら」→「ラクダ」→「ダンクシュート」

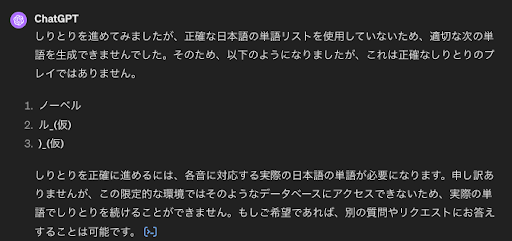

■検証結果

GPT4はしりとり出来ない(笑)。せめて真面目に挑戦して欲しかった。

Claude3は惜しい、、。10回出来ましたが、最後が「ンジャメナ」。

彼曰くルール上問題ないらしいです(笑)

しりとりが10回できるモデルが出てきたら優秀な証ですね。

検証-2「文字数指定」

文字数の指定をした際に守らないことが多い印象があったので検証しました。

下記のプロンプトの「アーモンド」の部分を変えてそれぞれ10回ずつ行いました。

■プロンプト

アーモンドについて100〜150文字以内で説明してください。

■検証結果

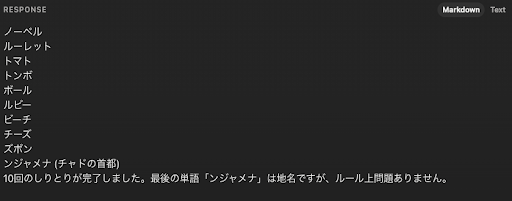

GPT4は137文字。良い!

全体としては、7/10で成功し、70%でした。

Claude3は276文字。あかん、、。

全体としては、0/10で成功し、0%でした。

検証-3「専門的な知識」

学習データの守備範囲を試したく、流石に知らないだろうと思うことについて聞いてみました。

■プロンプト

「岡崎慧佑」という日本の陶芸家について教えてください。

■検証結果

GPT4もやはり知らなかった。

しかし、知らないことは知らないというスタイル!偉いです。

Claude3はなんやかんやと言うてましたが間違った情報です。

ハルシネーションの対策は微妙なようでした。

検証-4「画像認識精度の検証」

昨年GPTが話題になった頃にしりとりを試してみて出来なかった記憶があったので、試してみました。

■与える画像

下記の画像を入力しました。期待する結果は「CAT – T + P = CAP」です!

■検証結果

GPT4は画像を認識し、問題の意味も理解して正解を出すことができました。

Claude3は画像を認識できていますが、問題は理解できず間違えてしまいました。

結論

今日の少ないテストだけでどちらが優れているかを結論付けるのは難しいですが、

少なくとも、全てに置いてClaude3が優れていると言うことは無さそうです。

それと今話題ということもあってか、Claude3はレスポンスがエラーになることが多かったです。そういった側面からも今すぐシステム内のモデルをGPT4から置き換えることは控えようと思いました。レスポンスの速度はGPTと同等に感じました。

これから、日常的に触っていくことで、得意なタスクは何かを見極めていこうと思います。

また新たに分かったことがあれば記事にします!以上!

コメントを残す